Понятие энтропии используется в различных науках: физике, химии, математике, биологии, социологии. Само слово произошло от греческого и обозначает «превращение, изменение». Что это такое простыми словами? Можно сказать, что это мера беспорядка, хаотичности в любой системе. Чем меньше порядка, тем больше ее значение. Если книги стоят на полке, неупорядоченность у них меньше, чем если они лежат кучей.

Что означает термин

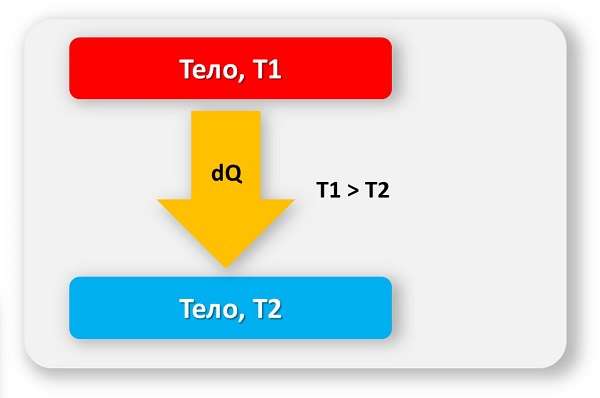

Определение данного термина зависит от сферы его применения. В общих словах можно сказать, что это мера беспорядка и необратимого рассеяния энергии. Чем более упорядочена какая-то система, тем энергия более сконцентрирована. Например, если мы поместим горячий предмет в холодную воду, постепенно он остынет, а вода нагреется. Во втором случае энтропия больше.

Важно! Энтропия характеризует беспорядок. Чем она больше, тем меньше система упорядочена.

В качестве системы может выступать что угодно. В физике или химии это обычно газ, жидкость, твердое тело, набор определенного числа частиц. В информатике это может быть текст, в социологии группа людей.

Термин энтропия

Термин энтропия

В физике

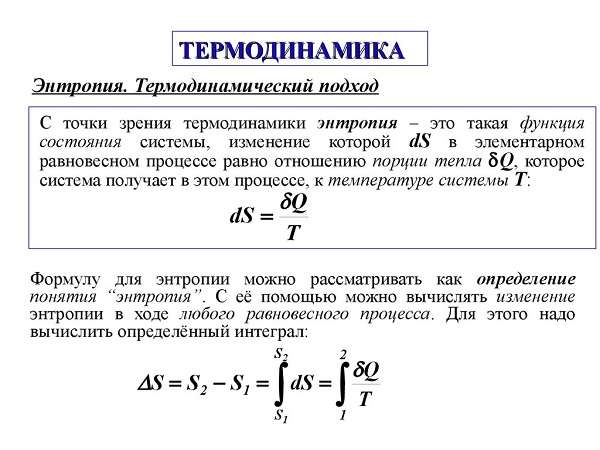

Этот термин используется в таких разделах физики, как термодинамика и статистическая физика. Термодинамика изучает способы передачи и превращения энергии. Она имеет дело с процессами, в которых можно использовать понятие температуры. Именно в термодинамике впервые начали использовать это понятие. Ввел его немецкий ученый Рудольф Клаузиус. Статистическая механика изучает поведение систем из конечного количества частиц, используя для этого методы теории вероятности.

В разных разделах физики этот термин означает несколько разные вещи. В термодинамике это характеристика необратимого рассеяния энергии. В статистической физике эта величина показывает вероятность какого-то состояния.

Это интересно! В чем заключается принцип теории Гюйгенса Френеля

В термодинамике

Энтропия — единственная величина, показывающая направление физических процессов. Что это значит?

- В изолированной системе, то есть той, которая не обменивается ни веществом, ни энергией с окружающими предметами, процессы всегда идут так, что неупорядоченность увеличивается. Достигнув максимума, она остается постоянной. В этом суть второго начала термодинамики.

- Обратимые процессы не меняют неупорядоченность.

- Необратимые процессы всегда идут так, что беспорядок увеличивается.

В открытой системе эта величина может возрастать или оставаться постоянной, возможны и такие процессы, при которых беспорядок уменьшается. То есть вмешательством извне мы можем уменьшить неупорядоченность.

Всякая система, находящаяся в неизменных внешних условиях, со временем приходит в состояние равновесия и не может самостоятельно из него выйти. При этом все ее части будут иметь одинаковую температуру. Это нулевое начало термодинамики.

В равновесии беспорядок больше всего. Например, есть сосуд, разделенный перегородкой. С одной стороны находится один газ, с другой — другой. Если убрать перегородку, постепенно газы смешаются и самостоятельно уже не разделятся снова. Такое состояние будет более беспорядочным, чем состояние, когда газы были разделены.

В физике эта величина — функция состояния системы. Это значит, что она зависит от параметров системы:

- температуры,

- давления,

- объема,

- внутренней энергии.

Это интересно! Формула закона полного отражения и преломления света

В статистической механике

В статистической механике это понятие связано с вероятностью получить определенное состояние. Например, для нескольких предметов или частиц она зависит от числа способов их расположить.

Есть несколько определений этой величины. Наиболее простое определение Больцамана. Она равна логарифму вероятности состояния, умноженному на постоянную Больцмана: S=k*ln(W).

Полезное видео: что такое энтропия

Абсолютное значение

Энтропия — величина неотрицательная (больше или равна нулю). Чем ближе температура к абсолютному нулю, тем она тоже ближе к нулю. Это третье начало термодинамики. В первоначальном виде его сформулировал Макс Планк в 1911 году.

Также третье начало термодинамики называют принципом недостижимости абсолютного нуля. Это значит, что при любых процессах, связанных с изменением неупорядоченности, невозможно достигнуть абсолютного нуля (0К, или -273,15 С). Можно только бесконечно приближаться к этой температуре. Ученые договорились, что при 0 К неупорядоченность равна 0.

Важно! Абсолютное значение неупорядоченности можно посчитать как изменение энергии при данной температуре.

В термодинамике обычно не имеет значения абсолютная величина, важно только ее изменение. Однако можно найти и абсолютное значение. Оно вычисляется по разным формулам для твердого, жидкого и газообразного состояния вещества. Эта величина измеряется в Дж/К или Дж/градус, то есть в тех же единицах, что и теплоемкость. Удобно поделить эту величину на массу или количество моль вещества. Поэтому используют единицы Дж/(моль*К) или Дж/(моль*градус) в зависимости от того, в чем измеряется температура — в кельвинах или градусах.

Это интересно! Формулировки законов Исаака Ньютона: кратко и понятно

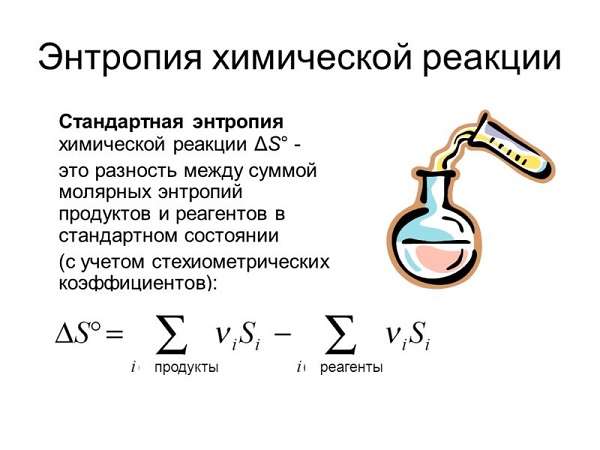

В химии

Что такое, к примеру, энтропия в химии? Это понятие применяется в химической термодинамике. Здесь важно изменение этой величины. Если оно положительно, то и система становится менее упорядоченной. Знать это важно для определения направления химических реакций и изменения химического равновесия. Этот термин связан с понятием энтальпии — энергии, которую можно превратить в тепло при определенном постоянном давлении.

По изменению неупорядоченности можно определить, может ли реакция протекать самопроизвольно. Этого нельзя сделать только по изменению энергии, так как существуют и реакции, протекающие с поглощением тепла, и реакции, протекающие с его выделением. Согласно второму началу термодинамики, состояние с наибольшей неупорядоченностью — это наиболее устойчивое состояние замкнутой системы. Также любая замкнутая система стремится к наименее упорядоченному состоянию. Поэтому при самопроизвольных процессах беспорядок возрастает.

Это интересно! Квантовые постулаты Нильса Бора: кратко об основных положениях

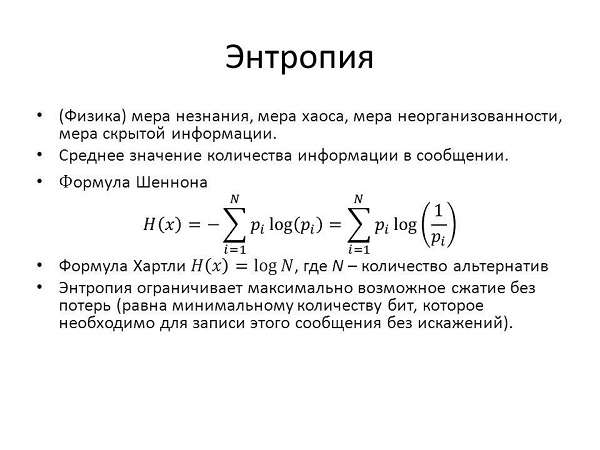

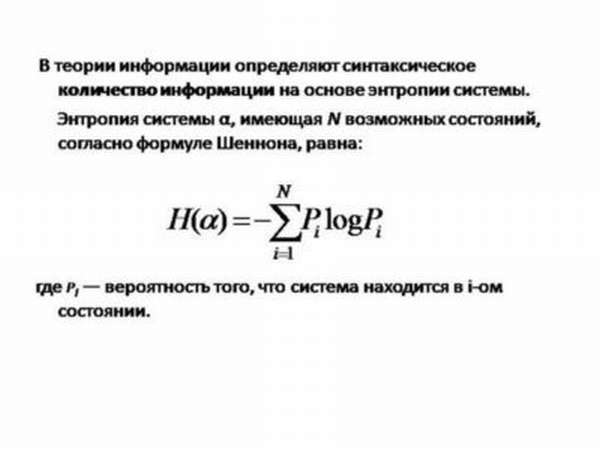

В теории информации

Информационная энтропия характеризует непредсказуемость какой-либо системы. Например, это может быть вероятность появления какого-то символа из алфавита в тексте. При этом эта функция равна количеству информации, которое приходится на один символ. Клод Шеннон — ученый, который ввел этот термин в теории информации, — даже сначала хотел называть эту величину информацией.

Шеннон предположил, что, увеличивая количество информации, мы уменьшаем неопределенность. Упорядочивая систему, мы также уменьшаем неопределенность.

Важно! Чем более предсказуемо какое-то событие, тем оно менее информативно, и тем меньше беспорядок.

С помощью этой неопределенности можно предсказывать события, например, исход какого-то эксперимента. Для этого события делят на отдельные части и считают неопределенность для них.

Информационная энтропия связана с числом доступных состояний. Чем это число больше, тем она больше. Например, если мы будем играть в шахматы по правилам, для шахматной доски эта величина будет меньше, чем если переставлять фигуры хаотически. Неопределенность для монетки, которая может упасть только на одну или другую сторону, меньше, чем у игральной кости с 6 гранями, а у кости с 20 гранями эта величина еще больше.

Существует также энтропия языка. Это понятие обозначает количество информации на единицу текста на этом языке (одни символ) и измеряется в битах на букву. Для разных языков она разная.

В языке одни символы появляются чаще, другие реже, также есть определенные часто встречающиеся сочетания символов. Проводя анализ вероятности появления того или иного символа, можно декодировать зашифрованный текст. Информационная неупорядоченность также помогает устанавливать необходимую пропускную способность каналов для передачи зашифрованных сообщений.

Для анализа данных в самых разных сферах, от медицины до социологии, используется информационно-энтропийный анализ. Простыми словами можно сказать, что, анализируя увеличение или уменьшение беспорядка, можно установить связи между явлениями.

Понятие «информационная энтропия» используется также в математической статистике и статистической физике. Эти науки также имеют дело с вероятностью различных состояний и используют методы теории вероятности.

Это интересно! Какие бывают системы отсчета в физике и что это такое

В экономике

В экономике используется понятие «коэффициент энтропии». Он связан с концентрацией продавцов на рынке. Чем больше концентрация, тем меньше этот коэффициент, или индекс. Он зависит от распределения долей между фирмами на рынке, и чем больше разница в величине этих долей, тем больше и коэффициент энтропии.

Если поделить этот индекс на количество фирм на рынке, получится относительный показатель. Он обозначается буквой Е. Его значение находится между 0 и 1. Значение Е=0 соответствует монополии, а Е=1 — совершенной конкуренции.

Что говорит википедия

В википедии можно найти разные определения этого понятия. Самое общее — это мера необратимого рассеяния энергии, отклонения реального процесса от идеального. Также в википедии можно найти:

- статьи об этом термине в классической термодинамике,

- в биологической экологии,

- энтропию Вселенной,

- языка,

- дифференциальную,

- топологическую,

- информационную.

Полезное видео: представление об энтропии

Заключение

Термин «энтропия» впервые был использован в термодинамике Рудольфом Клаузиусом. Из физики он пришел и в другие науки. Это понятие обозначает неупорядоченность, хаотичность, непредсказуемость и тесно связано с вероятностью. Энтропийный анализ помогает изучать данные и находить связи между явлениями, определять направления физических и химических процессов.